После создания robots txt его можно проверить на правильность работы.

Когда роботы (боты) поисковых машин заходят на любой сайт, то первым делом они ищут в корневой директории robots txt, который содержит указания боту какие разделы (папки) следует принимать во внимание, а какие нет.

Если этот файл неправильно сделан, то появятся дубликаты страниц, которые вредят сайту (влияют на поисковое продвижение).

Проверить правильность robots txt можно по поисковой машине Яндекса, так и Google.

Яндекс предлагает такой инструмент проверки как Яндекс Вебмастер.

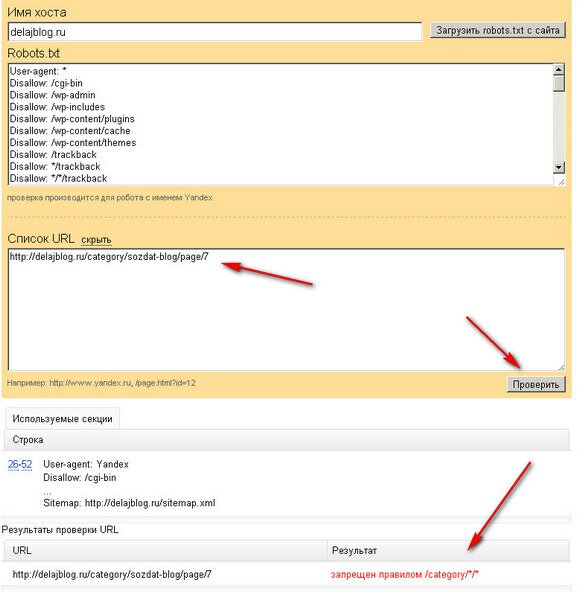

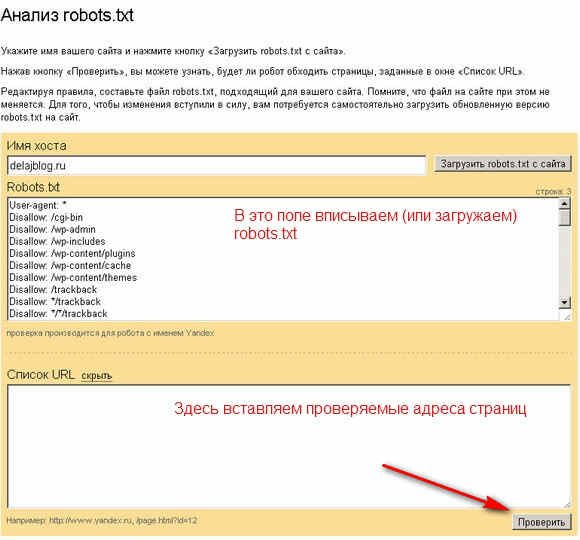

В поле под кнопкой «Имя хоста» можно загрузить файл с сайта (если он уже закачан в корневую директорию сайта). Он появится в соответствующем окне. Но в это поле можно скопировать любой файл для проверки. В поле «Список URL вставляем проверяемые файлы. После этого нажимаем кнопку «Проверить». Сам Яндекс обращает внимание, что все в нём изменения находящимся на сайте не происходят. Т.е. это инструмент только проверки, проверили файл на работоспособность и его нужно закачать на хостинг.

Рассмотрим пример: проверяем действия файла на блоге https://delajblog.ru/ А проверяемая страница https://delajblog.ru/category/sozdat-blog/page/7

Видим результат, что данный robots txt запрещает индексировать страницу каталогов (категорий) https://delajblog.ru/category/sozdat-blog/page/7 и указано каким правилом —

Видим результат, что данный robots txt запрещает индексировать страницу каталогов (категорий) https://delajblog.ru/category/sozdat-blog/page/7 и указано каким правилом —

правилом /category/*/*

Совершенно аналогично можно проверить robots txt и на сервисе «Инструменты для веб-мастеров» от Google (Панель инструментов -> Заблокированные URL).

Оказалось так просто!